使用 Transformer 模型生成文本 (Generating text with transformers)

Transformers的主要组件:前文提供了Transformers架构中一些主要组件的高层次概览。

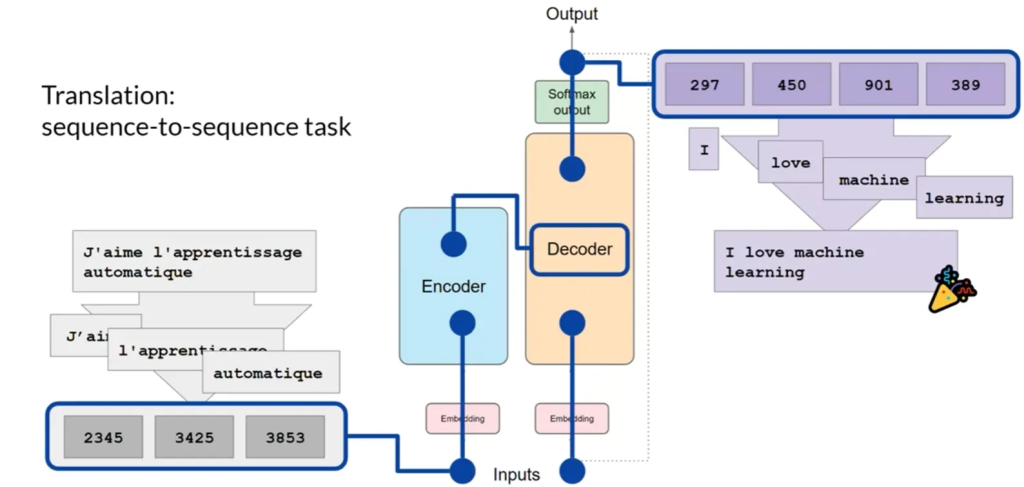

翻译任务示例:如何使用Transformers模型将法语短语翻译成英语。这种翻译任务或序列到序列的任务正是Transformers架构设计的初衷。

翻译任务示例

输入的处理: 首先,使用与训练网络时相同的分词器对输入词汇进行分词。这些分词结果随后被加入到编码器(Encoder)端的网络中,经过嵌入层(Embedding Layer),然后传递到多头注意力层(Multi-Headed Attention Layers)。

编码器的输出:多头注意力层的输出经过前馈网络后形成编码器的输出。这个输出代表了输入序列结构和意义的深层表示。

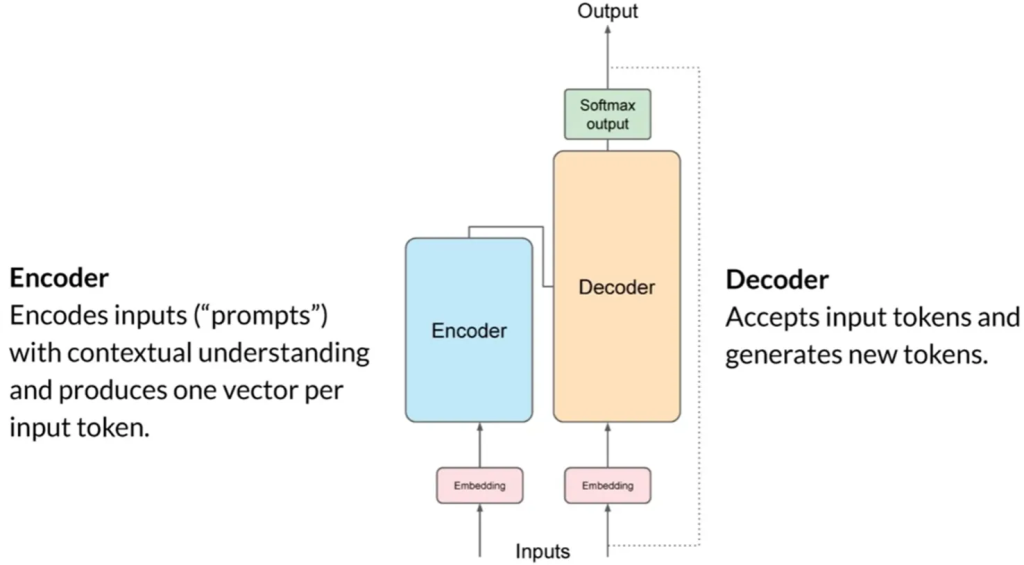

编码器-解码器

解码器的处理:这个深层表示被插入到解码器(Decoder)中,影响解码器的自注意力机制。解码器从“序列开始”标记开始工作,基于编码器提供的上下文理解预测下一个标记。

输出生成循环:解码器的自注意力层的输出经过解码器的前馈网络和最终的softmax输出层。这个过程形成了第一个输出标记。这个循环继续进行,将输出标记传回输入以触发下一个标记的生成,直到模型预测出“序列结束”标记。

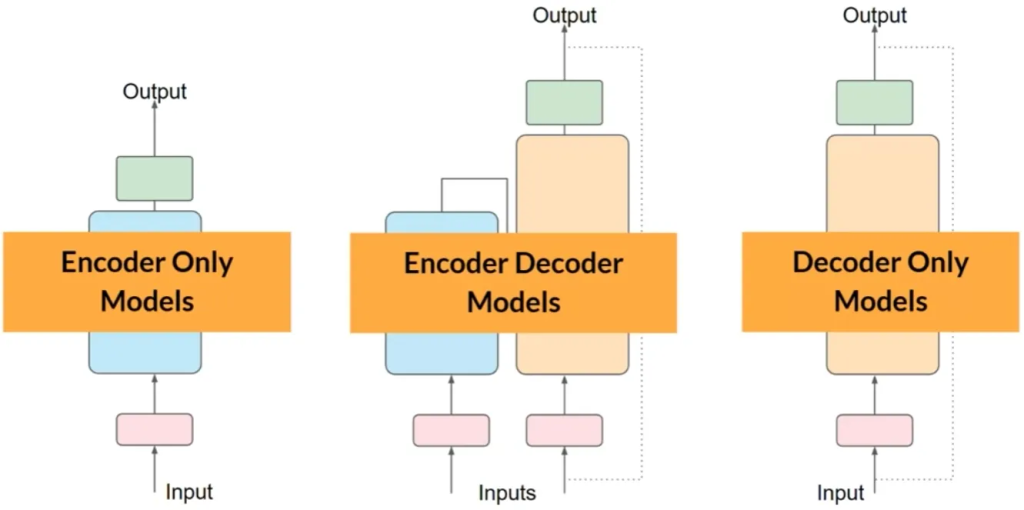

不同模型结构的应用: 虽然翻译示例使用了编码器和解码器部分,但可以将这些组件分开,以适用于不同架构的变体。编码器-解码器模型擅长处理翻译等序列到序列任务,而解码器单独模型则广泛用于文本生成。

模型类型:

- 编码器-解码器模型:如BART和T5,适用于翻译等任务。

- 编码器单独模型:如BERT,通过增加额外层可用于情感分析等分类任务。

- 解码器单独模型:如GPT、BLOOM、Jurassic、LLaMA等,现可用于大多数任务。

提示工程:用户通过自然语言与Transformers模型交互,使用书面文字创建提示(prompts).